Vamos allá. Venimos a darlo todo. Estos son los principios básicos a la cuestión de ¿Cuáles son los factores clave a tener en cuenta para posicionar? En nuestra trayectoria como Agencia, hemos experimentado cuáles son las áreas que más nos están dando resultados. Nuestros valores NO se basan en Hackear a los buscadores sino en hacer caso a las recomendaciones de Google y satisfacer al usuario.

Los 10 áreas más importantes de táctica SEO

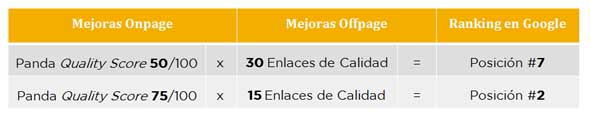

1) El SEO Onpage es más importante que en los últimos años

Esto no significa que el Linkbuilding haya dejado de ser importante sino que todo aquello que podamos hacer en nuestra web es un factor más importante para el robot de Google y los rankings en los SERPs. A más optimización interna, menos enlaces externos.

haya dejado de ser importante sino que todo aquello que podamos hacer en nuestra web es un factor más importante para el robot de Google y los rankings en los SERPs. A más optimización interna, menos enlaces externos.

2) Buena Estructura Web y Jerarquización de las URL

El ejercicio más complejo es conceptualizar como va a ser nuestra web y nuestro proyecto. Este es un factor muy importante que la mayoría de empresas no tienen claro y existen dificultades en categorizar una web. Insistimos en esto ya que se trata de una problema previo al desarrollo web. Por lo tanto,

i. Deberemos formar primeramente un Mapa Conceptual en función de nuestro producto, competencia y la demanda de Internet.

ii. Analizaremos y Estudiaremos los nichos de búsqueda en los buscadores.

iii. Reformularemos nuestro Mapa Conceptual inicial y lo cruzaremos con los nichos de búsquedas para formar definitivamente una Restructrucación Web Óptima para SEO (y SEM):

www.dominio.com

www.dominio.com/servicio-1

www.dominio.com/servicio-2

www.dominio.com/categoría-de-productos/

www.domindio.com/categorías-de-productos/subcategoria/

www.domindio.com/categorías-de-productos/subcategoria/producto-1

www.domindio.com/categorías-de-productos/subcategoria/producto-2

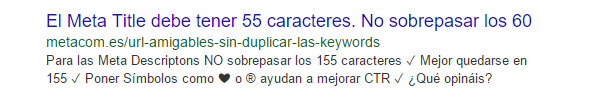

3) Las URL amigables y Metaetiquetas Optimizadas

Hay que seguir trabajando en este sentido. Las URL deben de ser amigables sin que sean extensamente largas. También, tendremos que seguir optimizando las Metaetiquetas/Metatags de los campos de Title y Description atendiéndoos a no superar los caracteres máximos recomendados por Google. Tener cuidado en NO duplicar las palabra clave en las URL ni el Title ni poner más de 2 en la Description .

.

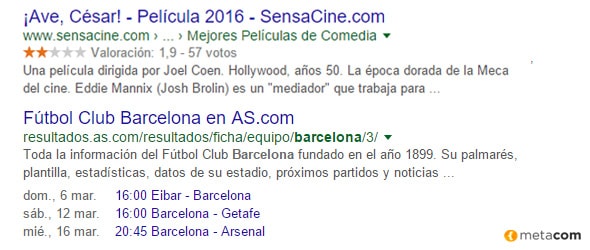

4) El uso de microformatos y RichSnippets (Fragmentos Enriquecidos)

Los Datos Estructuradoras para Google. Tenemos que USARLOS. Por un lado, bajo la iniciativa schema.org, se trata son las “reglas y normas neutrales para todos los buscadores”. Es decir, los buscadores de todo el mundo (Google, Yahoo y Bing) se han reunido para llegar a un acuerdo en usar unos códigos comunes que identifiquen una seria de elementos que ayudan a mejorar el posicionamiento. Como por ejemplo, recetas, opiniones, etc Por el otro lado, a nivel más técnico, tenemos 2 maneras diferentes para poder aplicar los fragmentos enriquecidos a nuestra web: i) mediante el marcado de microdatos y) JSON-LD. En ambos casos se puede codificar a mano y/o usando plugins o extensiones. Lo importante es saber que Google nos recomienda NO combinar los 2 sistemas en una misma web y preferiblemente usar el marcado por microdatos.

Por el otro lado, a nivel más técnico, tenemos 2 maneras diferentes para poder aplicar los fragmentos enriquecidos a nuestra web: i) mediante el marcado de microdatos y) JSON-LD. En ambos casos se puede codificar a mano y/o usando plugins o extensiones. Lo importante es saber que Google nos recomienda NO combinar los 2 sistemas en una misma web y preferiblemente usar el marcado por microdatos.

5) El CTR en los SERP’s y el Tiempo de Estancia en la Web

5) El CTR en los SERP’s y el Tiempo de Estancia en la Web

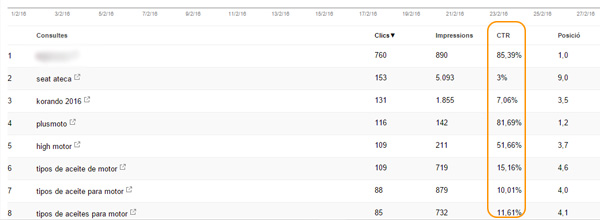

El Click Through Ratio para los resultados de Búsqueda. Esto lo podemos analizarlo en Google Search Console en Tráfico de Búsqueda –> Análisis de Búsqueda. El CTR es igual al número de clicks dividido por el número de impresiones por 100%. Este es uno de los factores que este 2015 ha cogido mucha fuerza y que seguirá importando en los próximos años ya que se trata de la manera de controlar que, frente a los resultados de búsqueda, una web se está llevando más clicks ya que se interpreta que el contenido es más interesante.

CTR = 100 x (Número de Clics / Impresiones)

Por ejemplo, para la palabra calve de Diseño Web Sabadell, nos aparece nuestro subdominio de https://sabadell.metacom.es/ nos aparece a día de hoy alrededor de la posición 33. Ponemos un ejemplo propio por el tema de la confidencialidad con nuestros clientes. Pues bien, para dicha palabra obtenemos 164 impresiones (es decir, se ha mostrado 164 veces en los resultados de búsqueda) y sólo se ha ha hecho un click. Por lo tanto, tenemos un CTR del 0,61%. Es bajo. En las primeras posiciones (si no hay campañas de AdWords activas) solemos tener CTR superiores al 80% ya que es natural.

6) Trabajar la comunicación en las Redes Sociales

Son importantes. Si una página web / URL / Proyecto online está soportada por una masa crítica real en las redes sociales es un factor clave para rankear. Hay que potenciar y medir esfuerzos en las Redes Sociales. Priorizar las más importante y tener en cuenta el objetivo en cada una. No todas las redes sociales sirven ni se usan para lo mismo. Existen diferentes maneras de comunicar y de explicar contenido para cada una de ellas. Los enlaces desde Redes Sociales funcionan bien si son cuentas «reales».

Por ejemplo, tenemos el caso de MissWood, especialistas en elementos decorativos de madera y de corcho para el hogar. En este imagen, podemos ver como el TOP Contenido más compartido en las Redes Sociales es su producto Woody Map. Se trata de un mapamundi de corcho en diferentes tamaños para marcar los países dónde uno a estado. Bien, a través de la herramienta Ahrefs podemos ver que se ha «compartido» hasta casi 10.000 veces por Facebook y 2100 veces en Pinterest.

Por ejemplo, tenemos el caso de MissWood, especialistas en elementos decorativos de madera y de corcho para el hogar. En este imagen, podemos ver como el TOP Contenido más compartido en las Redes Sociales es su producto Woody Map. Se trata de un mapamundi de corcho en diferentes tamaños para marcar los países dónde uno a estado. Bien, a través de la herramienta Ahrefs podemos ver que se ha «compartido» hasta casi 10.000 veces por Facebook y 2100 veces en Pinterest.

7) El contenido: texto, imágenes y vídeos

El contenido debe der ser de calidad. Tenemos que insistir en esto. Un buen contenido que resuelva las inquietudes/preguntas del internauta es de valor.

- • Tener sólo H1 por cada URL. Luego, usar H2, H3, etc.

- • El Contenido es el Rey para Google.

Desde marzo de 2014 la línea de tráfico y palabras claves sigue una tendencias constante. Recordamos que en Marzo-Mayo de 2014 es la actualización de Google Panda 4.0 presentado por Matt Cutts. Se enfoca hacía 2 objetivos muy claros:

- • Premiar el Contenido de Calidad: es decir, hay que evitar contenido duplicado y “ganará” aquel contenido que realmente sea de interés para el usuario.

- • La experiencia de usuario: el lector tienen que tener una una óptima experiencia de usuario. No sólo en una buena lectura si no en otros aspectos como: velocidad de carga y NO intrusión con los anuncios. Buscar el equilibrio perfecto

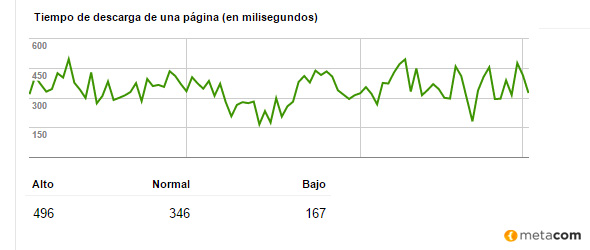

8) La Velocidad de Carga y la Respuesta del Servidor

Los buscadores la tienen en cuenta y sobre todo Google. De manera aproximada, una web debe estar por debajo de 1 segundo en cuanto a respuesta del servidor. Si es posible hacerlo bajar por debajo de 0,8 segundos mucho mejor. No se recomienda que la web supere los 1,5 segundo en tiempo de carga ya que no es de agrado para el robot de Google. Por ejemplo, mediante Google Search Console –> Rastreo –> Estadísticas de Rastreo podemos analizar que en esta web el tiempo de descarga de una página es inferior a 0,5 segundos (496 milisegundos para ser exactos) en el momento que el robot ha invertido más tiempo. En el mejor de los casos la descarga se produce en 167 milisegundos.

Por ejemplo, mediante Google Search Console –> Rastreo –> Estadísticas de Rastreo podemos analizar que en esta web el tiempo de descarga de una página es inferior a 0,5 segundos (496 milisegundos para ser exactos) en el momento que el robot ha invertido más tiempo. En el mejor de los casos la descarga se produce en 167 milisegundos.

9) Los algoritmos de Google cada vez más inteligentes

Los algoritmos sacados por Google para frenar a técnicas fraudulentas son cada más inteligentes. Así que, deberemos saber que Panda, Pingüino y Colibrí cada vez saben más de trucos Black Hat.

• Panda: el algoritmo que analiza el contenido – texto de una página web.

• Pingüino: el algoritmo que controlar los enlaces de una web.

• Colibrí: el algoritmo semántico. La semántica léxica. El significado de una oración. Aún tiene que desarrollarse mucho más.

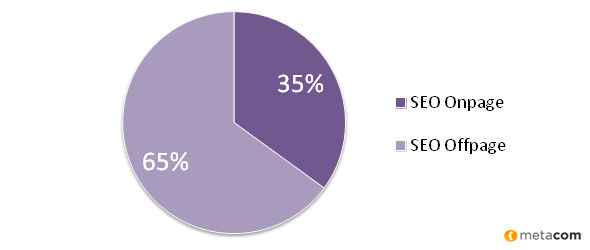

10) Táctica de Linkbuilding y el Linkbaiting

El SEO Offpage en toda regla. La parte más compleja y uno de los factores importantes para el posicionamiento SEO. Hay profesionales que consideran que una buena estrategia de Linkbuilding equivale al 65% del éxito para rankear un portal web.

- · Linkbuilding: táctica de construir enlaces. Tanto a nivel interno como externo.

- · Linkbaiting: táctica para controlar con qué anchor text se construye un enlace.

En resumen, llevar a cabo una Estrategia de SEO no es tarea fácil. Se requiere personal especializado con experiencia. Y no olvidéis que la acciones de posicionamiento web siempre se basan en atender las recomendaciones de Google.